เจาะลึก Generative AI ตอนที่ 1: รู้จักกับ Stable Diffusion อีกหนึ่ง Generative AI ที่อาจจะมา Disrupt วงการ Concept Designer !

Generative AI ที่เราคุ้นเคยคือแบบ text-to-text แบบ ChatGPT ที่เราสามารถป้อนคำสั่งเป็นข้อความ (Prompt) เข้าไปเพื่อให้มันตอบกลับมาเป็นข้อความได้ แต่ความจริงแล้วยังมี Generative AI ในรูปแบบอื่นๆอีกเพียบ เช่น text-to-image, text-to-video, text-to-speech ที่เราสามารถพิมพ์ข้อความเข้าไปแล้วได้ผลลัพธ์เป็น ภาพ วิดิโอ และเสียงได้นั่นเอง

.

Stable Diffusion (SD) คือหนึ่งใน Generative AI แบบ text-to-image และ image-to-image ที่มาแรงมากๆ เรียกได้ว่าเป็นคู่แข่งหลักของ Midjourney (MJ) ซึ่ง SD ถูกพัฒนาโดย Startup อย่าง Stability AI ในเดือนสิงหาคมปี 2022 เป็นช่วงที่ภาพนักบินอวกาศขี่ม้าที่ Generate จาก AI กำลังดัง ผู้อ่านน่าจะเคยเห็นกันมาบ้าง หนึ่งในภาพนั้นแหละครับ ที่สร้างจาก SD

.

แต่สิ่งสำคัญที่ทำให้ SD เป็นที่นิยมมาก คือมันเป็นเจ้าเดียวที่ให้ใช้ฟรี! ใช่ครับ Stability AI ผู้พัฒนาได้ปล่อยโค้ดเบื้องหลังการทำงานของ SD ออกมาให้เราใช้กันโดยไม่ต้องเสียเงินจ่ายใดๆ เพราะบริษัทหวังจะให้ Developer ทั่วโลกช่วยกันนำ SD ไปพัฒนาต่อยอด และทำให้อุตสาหกรรม AI เร่งตัวไวขึ้นไปอีกนั่นเอง

.

ธุรกิจหรือกลุ่มอาชีพ Concept Designer ในระดับ Entry กำลังเจอปัญหาหนัก!

.

พอ Developer ทั่วโลกสามารถเอา SD ไปลองพัฒนากันอย่างสนุกสนาน เพียงไม่กี่เดือน SD ก็มี Community เกิดขึ้นมากมาย พร้อมกับ Model ที่ผุดเป็นดอกเห็ดมากกว่า 1,000 โมเดล ส่งผลให้ SD สามารถ Generate ภาพได้หลาย Art Style มากขึ้น อยู่ที่ว่า Developer เอาภาพอะไรมาเทรน

.

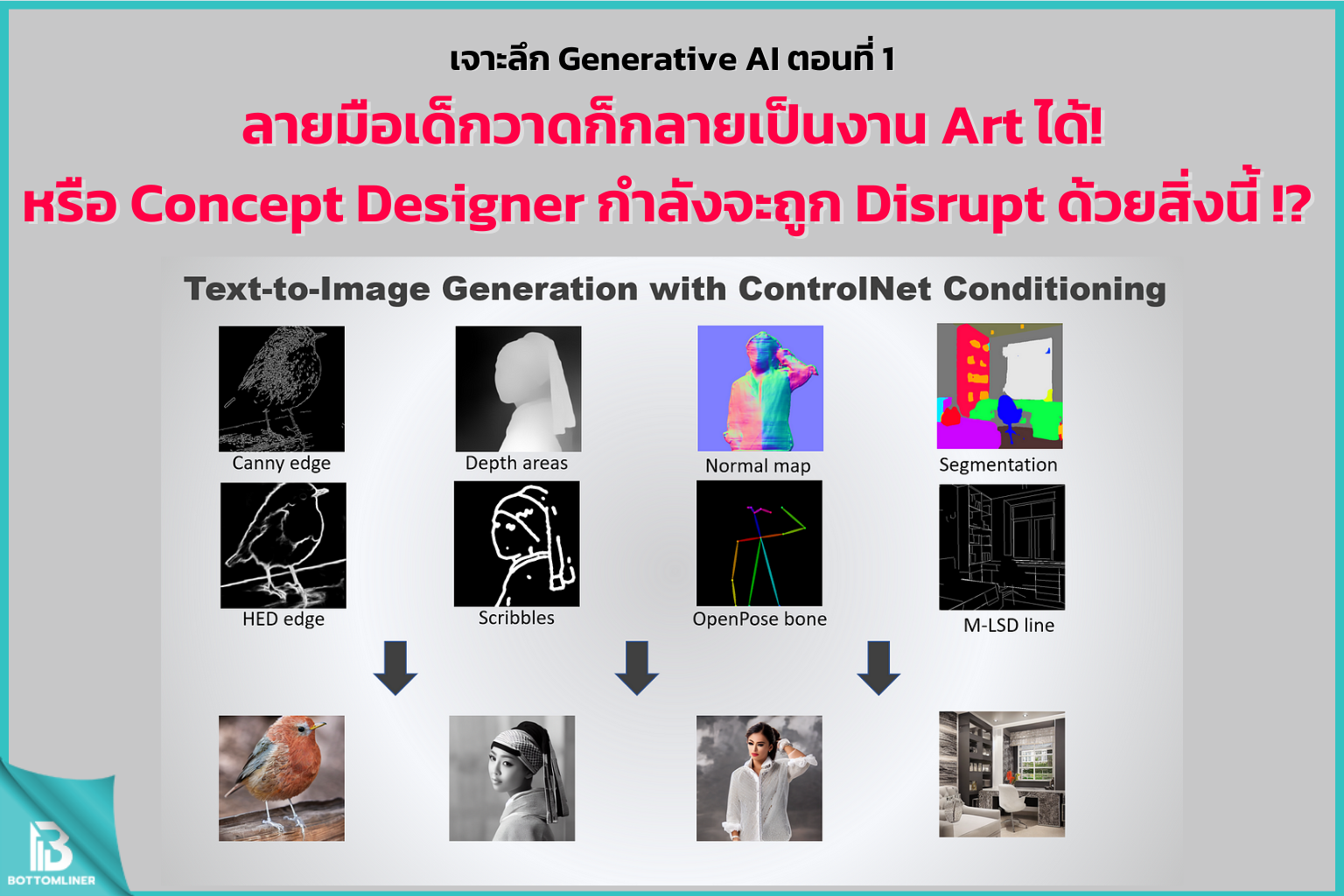

แต่จุดเปลี่ยนของวงการก็มาถึงเมื่อต้นปีที่ผ่านมา เมื่อ Stability AI ปล่อย “ControlNet” ที่เป็นส่วนเสริมของ SD ให้ Developer โหลดไปใช้ฟรีๆอีกแล้ว โดยเจ้า ControlNet นี้จะช่วยให้เราเพิ่มภาพ Reference เข้าไปช่วยกำกับการ Generate ภาพของ SD ได้ เช่น ภาพ Sketch, ภาพแปลนบ้าน, ภาพ Concept Art ตัวละคร เป็นต้น (แนะนำให้ดูตัวอย่างในรูปด้านล่างนะครับ)

.

การมาของ ControlNet เลยจะทำให้วงการ Concept Designer ถูก Disrupt ได้ง่ายๆ เพราะหลังจากนี้บริษัทอาจไม่ต้องจ้างคนระดับ Entry มาวาด Concept Idea แรกเริ่มอีกต่อไป เพราะใช้ AI ประหยัดต้นทุนและเวลาได้อย่างมากนั่นเอง

.

แต่ SD ยังคงมีข้อถกเถียงและข้อจำกัดบางอย่างที่สำคัญ

เรื่องแรกคือภาพที่ Developer นำมาเทรนนั้นอาจเป็นภาพที่ผิดลิขสิทธิ์ก็ได้ ส่งผลให้เราเริ่มเห็นบางคนออกมาฟ้องร้องเรื่องถูกละเมิดลิขสิทธิ์จากบริษัทผู้พัฒนา AI เหล่านี้ ส่วนอีกเรื่องคือ SD ไม่ได้ Generate ภาพที่มีคุณภาพดีออกมาได้ในครั้งแรกทันที จะต้องเอาไปแก้รายละเอียดที่ผิดพลาดเพิ่มอีกต่อหนึ่ง โดยเฉพาะภาพมือ ที่ SD ไม่ถนัดเอามากๆ

.

ซึ่งผู้ใช้จะแก้รูปบน SD เลยก็ได้ เพราะ SD มี Feature ให้ครบ จบงานได้ในตัว หรืออีกทางเลือกหนึ่งที่มาแรงตอนนี้เลยคือ การใช้ Generative Fill ที่เป็น Feature ใหม่บน Adobe Photoshop ซึ่งสามารถใช้แก้มือได้ดีและรวดเร็วที่สุดตอนนี้ก็ว่าได้

.

สรุป Stable Diffusion เป็นหนึ่งใน Generative AI ที่มีประโยชน์ต่อธุรกิจที่พึ่งพา Concept Design ในกระบวนการทำงานอย่างมากไม่ว่าจะเป็น Digital Ads, Movies, VR/AR และ Game กลับกัน SD จะทำให้คนระดับ Entry

ตกงานเพราะโดน AI แทนที่ แต่เหล่าคนที่อยู่ในตำแหน่ง Senior จะยังรอดเพราะต้องคอยเป็นคน Finalize และตรวจสอบความถูกต้องของ AI ให้เรียบร้อยก่อนเข้ากระบวนการต่อไป

.

สำหรับใครที่ชอบ Content เจาะลึก Generative AI แบบนี้ อย่าลืมกดแชร์และรอติดตามตอนต่อไปนะครับ

.

BottomLiner